はじめに

ディープラーニングE資格(JDLA主催)のオンライン講座(ラビットチャレンジ)を受講したときの学習記録になります。

E資格の一通りの科目をカバーしています。学習の参考にしてください。

科目一覧

- 応用数学 ←ココ

- 機械学習

- 深層学習(day1)

- 深層学習(day2)

- 深層学習(day3)

- 深層学習(day4)

第一章:線形代数

固有値分解とは

特異値分解とは

正方形以外のものを固有値分解する方法

このような特殊な単位ベクトルがあるならば特異値分解ができる

UやVは直交行列になる

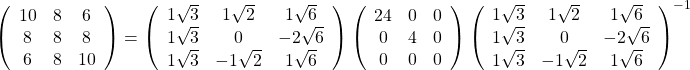

特異値の求め方

例題

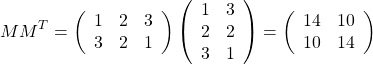

以下のような行列がある。

![]()

これに、自分を転置した行列を掛ける。出来上がる正方形の行列は、対称形になる。

これを固有値分解して

![]()

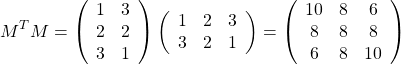

逆の場合。つまり![]() が先に来る場合

が先に来る場合

これも同様に、出来上がる正方形の行列は、対称形になる。

これを固有値分解して

特異値分解の応用例

ある白黒2色の画像を、濃淡情報を数字として捉えた2次元の数字の配列と考えることができる。

さらに、配列の固有値から特定の情報だけ取捨選択すると、解像度を下げたような画像ができる。たとえば左側の画像から特異値の128だけを残すと、右側のようになる。

上記のように特異値分解を用いれば、元の画像の情報量を減少させて表示したり、複数の画像の特徴の共通点を見出すことに応用することができる。これは実際によく使われている。

第二章:確率・統計

ベイジアン確率

例題

共分散

例題

ベルヌーイ分布

・コインを投げたとき、表が出る(x=1)場合は![]() である。裏が出る(x=0)場合は

である。裏が出る(x=0)場合は![]() である。

である。

・表と裏の出る確率が同じ(つまり![]() =0.5)でなくても、使える。

=0.5)でなくても、使える。

![]()

二項分布

・ベルヌーイ分布の多試行版

![]()

ガウス分布

![]()

第三章:情報理論

・自己情報量

たとえば16個の事象が起こりうるとき、

自己情報量: ![]() ※ただし対数の底を2で取った場合

※ただし対数の底を2で取った場合

また、同じことを事象の確率で求めることができる。

その事象が![]() の確率で起こる場合、自己情報量:

の確率で起こる場合、自己情報量:![]()

※単位について

対数の底が2のとき,単位はビット(bit)

対数の底がネイピアのeのとき,単位は(nat)

・シャノンエントロピー

自己情報量の期待値

・カルバック・ライブラー・ダイバージェンス

同じ事象・確率変数における異なる確率分布P,Qの違いを表す

・交差エントロピー

次章でまとめる。

ご紹介: E資格対策講座 ラビットチャレンジについて

E資格を受けるには、対象の講座の修了が必要です。

ラビットチャレンジは「現場で潰しが効くディープラーニング講座」の通学講座録画ビデオを編集した教材を活用したコースです。

質問等のサポートはありませんが、E資格受験のための最安(2020年5月時点)の講座の一つです。

詳細は以下のリンクからご確認ください。